di Francesco Azzarello

Premessa. Primo contatto con Ganesh. Psiche e techne: ubi sunt?

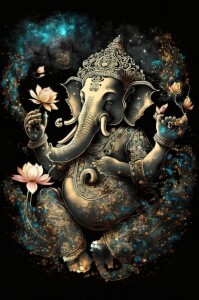

Testa d’elefante (a simbolizzare intelligenza), grandi orecchie (capacità di ascolto), proboscide (grande fiuto nel distinguere il reale dall’irreale), una zanna evince di due (a superare ogni dualismo), corpo d’uomo con una grande pancia (perché digerisce tutto con calma e serenità), spesso quattro braccia, spesso rappresentato mentre cavalca, a volte da seduto nella posizione dei saggi, spesso servito da un topo (che rappresenta la mente con i suoi desideri), Ganesh, figlio di Siva e Parvati è uno degli dei più importanti del pantheon induista. È un dio molto venerato: rimuove gli ostacoli, dà prosperità e fortuna.

Se offra o meno una prospettiva antropologica proficua sull’enigma (rubo quest’espressione al matematico, specialista dl tema, Daniel Andler [1]) cui l’intelligenza artificiale espone l’umanità lo dirà chi sta leggendo una volta terminata la lettura. Per cominciare a cercarla, è necessario spostarsi nella zona occidentale del pantheon, la parte del mondo dove la scienza e la tecnica sembrano aver preso il sopravvento sui simboli disincantando il nostro esistere.

Anno Domini (visto che siamo in tema) 1999. Il noto filosofo Umberto Galimberti apriva così il suo classico Psiche e Techne. L’uomo nell’età della tecnica [2]:

«Siamo tutti persuasi di abitare l’età della tecnica, di cui godiamo i benefici in termini di beni e spazi di libertà. Siamo più liberi degli uomini primitivi perché abbiamo più campi di gioco in cui inserirci. Ogni rimpianto, ogni disaffezione al nostro tempo ha del patetico. Ma nell’assuefazione con cui utilizziamo strumenti e servizi che accorciano lo spazio, leniscono il dolore, vanificano le norme su cui sono state scalpellate tutte le morali, rischiamo di non chiederci se il nostro modo di essere uomini non è troppo antico per abitare l’età della tecnica che non noi, ma l’astrazione della nostra mente ha creato, obbligandoci, con un’obbligazione più forte di quella sancita da tutte le morali che nella storia sono state scritte, a entrarvi e a prendervi parte».

Se nel 1999 di fronte al potere della tecnica provare qualche rimpianto per un mondo più lento e meno incalzante poteva apparire patetico e il nostro modo di essere uomini anacronistico, la situazione, mentre scrivo, dà ragione al filosofo al cinquanta per cento: certamente nell’era dell’intelligenza artificiale il nostro modo di essere umani (e umane) è ormai anacronistico, per definizione visto che non siamo più o non lo saremo ancora per molto gli e le agenti più intelligenti a operare sul pianeta (le grandi imprese del settore si preoccupano giornalmente di ricordarcelo). Tuttavia provare qualche rimpianto per i tempi in cui lo eravamo non ha più nulla di patetico. È anzi, probabilmente, quel che oggi appare più sensato.

Se nel 1999 di fronte al potere della tecnica provare qualche rimpianto per un mondo più lento e meno incalzante poteva apparire patetico e il nostro modo di essere uomini anacronistico, la situazione, mentre scrivo, dà ragione al filosofo al cinquanta per cento: certamente nell’era dell’intelligenza artificiale il nostro modo di essere umani (e umane) è ormai anacronistico, per definizione visto che non siamo più o non lo saremo ancora per molto gli e le agenti più intelligenti a operare sul pianeta (le grandi imprese del settore si preoccupano giornalmente di ricordarcelo). Tuttavia provare qualche rimpianto per i tempi in cui lo eravamo non ha più nulla di patetico. È anzi, probabilmente, quel che oggi appare più sensato.

Persino la politica l’ha capito. Dopo l’Unione Europea anche gli Stati Uniti, la Cina e la Gran Bretagna hanno cominciato a intavolare discussioni e procedure per fissare regole di contenimento del fenomeno. Ma dietro i discorsi tranquillizzanti è evidente che, anche a quei tavoli, i rapporti di forza (Cina e USA a parte) sono cambiati: gli Stati sovrani fanno la voce grossa e richiamano all’ordine, ma i toni laconici delle aziende leader nel settore fanno molto più rumore. I loro fatturati stratosferici e i loro investimenti di ricerca, spesso superiori al PIL di uno Stato occidentale, fanno presagire che, regole nonostante, l’intelligenza artificiale cambierà la faccia della terra [3]. E non soltanto in meglio.

E il mondo intellettuale? Per riprendere una bella trovata di Umberto Eco: diviso fra i due assi cartesiani cui allude il titolo di questo paragrafo. E di cui darò soltanto le posizioni estreme. Sull’asse dell’integrazione: alcuni grandi luminari non più giovanissimi (di impianto umanista [4]) che tendono a sminuire il fenomeno costituiscono un primo polo. La loro posizione (echeggiando il principio verum-factum di Vico) si può riassumere così: nessuna macchina progettata da umani potrà mai superare in intelligenza chi l’ha creata. Molti ammettono di capirci ben poco d’intelligenza artificiale e di parlare per deduzione più che per cognizione di causa. Il che (insieme a computer dotati di memoria e capacità di calcolo di gran lunga superiori alle nostre in circolazione ormai da una cinquantina d’anni) sottrae realismo a questa, altrimenti, rispettabilissima posizione (ma basterebbero già le vecchie calcolatrici elettroniche a metterci in imbarazzo).

Al polo opposto dell’asse dell’integrazione un manipolo di intellettuali (di tutte le età e provenienze scientifiche) veramente espert* nel settore, sostanzialmente spregiudicat*, che pragmaticamente ci dicono che da qui a cinque o dieci anni si potranno fare cose mirabolanti [5]. E che si dovranno pur fare anche se saranno a vantaggio di pochi e a detrimento di molti (dando per scontato, ancora una volta con pochissimo realismo, che la temperatura crescente del pianeta accetti la proroga e rallenti la sua progressione, in attesa di un’intelligenza artificiale a venire, capace di fermarla veramente).

Qui l’asse dell’apocalisse: un terzo polo (opposto al quarto della massa fatalista degli e delle astenut*) di vere e proprie cassandre (il termine non vuole sminuire il fatalismo non rassegnato di tanti e tante serissim* intellettuali) che, imputando alla modernità (vuoi fraintesa, vuoi tradita o semplicemente applicata alla lettera rispetto a una sua definizione a posteriori piuttosto che al suo svolgersi storico) ogni male – dal colonialismo al naturalismo, dalla catastrofe ecologica alla dissoluzione degli ordini sociali dell’altro ieri – chiamano alla resistenza, al boicottaggio dei telefonini, alla resistenza civile, avvertendo però che per quanto dura ed eroica sarà la lotta finiremo comunque per soccombere [6].

Mettendo da parte l’aspetto politico fra integrazione e apocalissi queste quattro posizioni, se meditate sul piano della razionalità e dell’oggettività, cosa dicono in fondo di vero rispetto alla questione (oltre la loro, comune, intrinseca contraddittorietà)? La posizione umanista ingenua (noi umani siamo comunque più intelligenti) mi sembra implicare che ogni situazione disperata nella nostra storia non è risultata nell’ armageddon definitivo, quanto piuttosto nell’ennesimo collo di bottiglia evolutivo. La posizione pragmatica (se qualcosa di buono per qualcuno si può tecnicamente fare, non c’è alcun freno di ordine morale che tenga e quindi si farà) mi sembra volerci ricordare che le forze che stringono il collo alla bottiglia sono già all’opera (e quindi bisogna sbrigarsi a reagire), la terza (avverto che siamo già perduti ma sarà bello morire battendosi) che a superare questo collo di bottiglia riusciranno soltanto i e le più adatt*[7].

Sarà dunque dura l’ora che arriva, ma non sarà l’ultima. Se è lecito sperare che l’inevitabile caduta dal trono dell’antropocene non significherà l’estinzione per la nostra specie, non è per niente chiaro, però, cosa ogni individuo dovrebbe fare per adattarsi a una nuova esistenza, comoda e creativa quanto si vuole, ma comunque vassallare. La situazione è talmente inedita (o così sembrerebbe) che disegnarne i contorni esterni è difficile almeno quanto orientarvisi dal di dentro: nessuno sa che aspetto avrà il mondo per i nuovi animali che saremo né, di conseguenza, quali competenze ci porteranno fuori dalla bottiglia [8]. Quel che è certo è che siamo a un punto di svolta nella nostra storia. Ma, bisogna ammetterlo in tutta onestà, questa svolta non giunge sul nostro cammino improvvisa come fulmine a ciel sereno.

Sarà dunque dura l’ora che arriva, ma non sarà l’ultima. Se è lecito sperare che l’inevitabile caduta dal trono dell’antropocene non significherà l’estinzione per la nostra specie, non è per niente chiaro, però, cosa ogni individuo dovrebbe fare per adattarsi a una nuova esistenza, comoda e creativa quanto si vuole, ma comunque vassallare. La situazione è talmente inedita (o così sembrerebbe) che disegnarne i contorni esterni è difficile almeno quanto orientarvisi dal di dentro: nessuno sa che aspetto avrà il mondo per i nuovi animali che saremo né, di conseguenza, quali competenze ci porteranno fuori dalla bottiglia [8]. Quel che è certo è che siamo a un punto di svolta nella nostra storia. Ma, bisogna ammetterlo in tutta onestà, questa svolta non giunge sul nostro cammino improvvisa come fulmine a ciel sereno.

I e le fatalist* non rassegnat* della terza posizione sostengono giustamente che l’avvento dell’intelligenza artificiale ha una sua causa, che qualcuno o qualcosa ne porta, in un certo senso, la colpa. E se la prendono giustamente con la modernità. Siamo (sostengono) alla resa dei conti degli ultimi duecento o cinquecento anni (a seconda se preferiamo il Rinascimento o la Rivoluzione industriale come punto di partenza di quel che ci ha portato fino a qua) ma è chiaro che si potrebbe andare anche molto più indietro: se Martin Heidegger ce l’aveva con la filosofia greca (fissata a suo dire troppo sull’ente e poco sull’essere), Philippe Grosos collega (ragionevolmente e con solide letture antropologiche) la nascita della filosofia al passaggio dal Paleolitico al Neolitico, descrivendo l’ontologia paleolitica come partecipativa (l’essere umano essendo uno e non il primo degli attori sulla scena terrestre) e quella neolitica come presenzialista (l’essere umano e il suo agire diventano regola e misura di tutto).

La situazione, insomma, più che inedita è arcaica e (se posso osare un’osservazione estetico-personale in questo contesto) anche buffa, considerando che corrisponde all’apice momentaneo del progresso umano. L’antropologia, di fatti, — e vorrei farlo notare con questo articolo — l’ha già registrata (non in un contesto paleolitico e persino con un certo buon umore). Ritengo che assumere una prospettiva antropologica permetta di vederci un po’ più chiaro nel nugolo di problemi legati a questa situazione. A tal fine mi accingo a descrivere lo studio che a mio modo di vedere serve meglio quest’obiettivo.

Ganesh e l’intelligenza artificiale

Ganesh e l’intelligenza artificiale

Pochi anni fa l’antropologo Emmanuel Grimaud (2021) ha pubblicato uno studio molto interessante dal titolo Dieu point zéro. Une anthropologie expérimentale, all’interno della celebre collana MétaphysiqueS (sic) (collezione filosofica ma all’interno della quale era già uscito nel 2015 il celebre Métaphysiques cannibales. Lignes d’anthropologie post-structurale di Eduardo Viveiros de Castro). Lo studio dava conto in normale stile etnografico di un esperimento (metodo non frequentissimo nelle scienze sociali) realizzato da Grimaud con la collaborazione dell’artista Zaven Paré. Di che si trattava? Di un’esperienza di contatto fra esseri umani, una macchina (una sorta di effigie robotica del dio Ganesh) e… la divinità stessa Ganesh (ovviamente non nel senso di un ingenuo realismo). La macchina-robot (chiamata Bappa) era un curioso assemblaggio consistente in un montacarichi a mano per trasporti su ruota, sormontato da uno schermo ovale, coronato da semplice fil di ferro, disposto in modo da disegnare grosso modo un cranio d’elefante. A completare il tutto: sullo schermo, all’altezza ideale del naso, una sorta di proboscide.

Come si svolgeva l’esperimento? l’idea era quella di portare in giro quest’idolo (religiosamente tale, visto che l’esperimento inizia proprio con il rituale d’apertura degli occhi, svolto presso un bramino) per le strade di Bombay (e in parte anche all’interno di un appartamento nella stessa città) durante le festività di Ganesh. Un officiante incarnante (il o la teleoperante, un po’ in disparte e munit* dell’occorrente per vedere, parlare e ascoltare) il cui viso sarebbe apparso sullo schermo di Bappa (la proboscide e le orecchie si muovevano in modo aleatorio) avrebbe fatto la parte del dio (ma liberamente, anche dicendo che non ne sta facendo la parte, di non essere, insomma, Ganesh), passanti perfettamente coscienti di cosa avevano davanti avrebbero fatto la loro di parte ovvero interloquire (anche loro liberamente) con l’idolo (di norma durante queste festività i fedeli si avvicinano devozionalmente, per offerte, voti o richieste, agli idoli di Ganesh). Lo studio registra, commenta e interpreta le conversazioni avvenute.

La concezione dell’esperimento mirava a dare ai partecipanti un esercizio che si annunciava interessante, soprattutto per due aspetti. In primo luogo per la sua intrinseca novità: con Ganesh, secondo uso e dottrina, si può parlare ma non si ricevono risposte immediate né verbali. Né di norma l’umano ne prende il posto. Per dirla con Grimaud stesso [9]:

«Bappa introduit d’abord un excès d’incarnation ou de personéité, là où la dévotion ordinaire n’en a pas besoin. Il injecte par ailleurs une possibilité de communication trop humaine, là où règne volontiers le silence ou l’accord tacite».

Novità dunque interessante perché promettente. Ma anche (e questo è il secondo motivo di interesse dell’esercizio) impossibile da portare a compimento, non contenendo Bappa, con ogni evidenza, il dio a cui ci si può rivolgere (dal lato degli interlocutori), e (da quello dell’officiante) non disponendo l’umano di capacità sovrumane o comunque tali da poter rispondere a tutto, accontentare richieste o fare promesse affidabili. Il regalo della sorte (poter conversare con l’idolo) si rivelerà tanto per gli e le officianti che per i e le passanti essere un vero e proprio cubo di Rubik. Un dono avvelenato che avrebbe indotto nei e nelle partecipanti delle situazioni di bug (stallo), portandoli inesorabilmente su piani limite dell’esperienza (come la parete verticale di una montagna per un alpinista diretto alla cima costituisce un ostacolo) ovvero riducendoli a veri e propri stati di impotenza (come davanti a un enigma nei termini di Andler). Quelle situazioni in cui i ricorsi tipici della propria identità sono andati in frantumi (il punto zero del titolo, concetto mutuato dalla fisica quantica) obbligando chi vi è dentro a reinventarsi (come l’alpinista reinventa ogni volta di fronte alla parete verticale il proprio modo di procedere). Infatti nell’interazione il gioco di forze sulle prime ha schiacciato le logiche abituali della religione tradizionale (fino allo stallo comunicativo) ma in molti casi ha finito per muovere i e le partecipanti a proseguire, a inventarne, performarne di nuove.

Qui un breve resoconto delle osservazioni di Grimaud rilevanti in questa sede. Nessuno prende mai il robot per un’incarnazione pura e semplice del dio. Grimaud parla di un’inevitabile cinetica del sospetto. Come in un test di Touring la gente si avvicina alla macchina e cerca di determinare cosa sia ponendole delle domande. La cinetica del sospetto si manifesta frequentemente in frasi del genere: la prevengo, io a questa roba qua non ci credo neanche minimamente oppure credo in dio ma non al fatto che possa essere qui oppure se sei dio perché hai preso questa forma? o nel migliore dei casi non credo a questo marchingegno ma visto che ci siamo ti faccio una domanda, Ganesh. La maggior parte della gente, dunque, non è interessata alla verità di Bappa come idolo di Ganesh (manifestamente falso anche se paradossalmente vero!). Quel che la incuriosisce spingendola a continuare l’esperienza è l’estensione delle sue possibilità, la voglia insopprimibile di esplorarla (ammesso che l’incarnante ci sappia fare).

Espressi i propri dubbi (a volte anche da parte dall’incarnante stess*) l’interazione tende infatti a continuare, con alterne fortune, verso una certificazione di identità metafisica (da dove vieni? Chi ti manda?…) che una volta superato un secondo turno di dubbi e un ulteriore possibile stallo coincide con la presa di coscienza che Bappa è più che un idolo normale e anche più che un(’)uman* corrente. Segue quindi una redistribuzione di potenza (incarichi e responsabilità): chi, fra umanità e divinità, ha causato un problema? E chi deve risolverlo?

Espressi i propri dubbi (a volte anche da parte dall’incarnante stess*) l’interazione tende infatti a continuare, con alterne fortune, verso una certificazione di identità metafisica (da dove vieni? Chi ti manda?…) che una volta superato un secondo turno di dubbi e un ulteriore possibile stallo coincide con la presa di coscienza che Bappa è più che un idolo normale e anche più che un(’)uman* corrente. Segue quindi una redistribuzione di potenza (incarichi e responsabilità): chi, fra umanità e divinità, ha causato un problema? E chi deve risolverlo?

Gli interlocutori e le interlocutrici passano molto tempo a mettere alla prova le capacità incarnanti dell’officiante. E non tutti se la sbrigano con la stessa perizia. Così il primo incarnante (il 26enne economista Karan) inizia dando corpo a un Ganesh abbastanza tradizionale, che promette ricompense e o concessioni se lo si adora con devozione e intensità, esattamente come uso vorrebbe si interpretasse la visita dei e delle fedel* a uno qualunque degli idoli di Ganesh durante le sue festività. Ma Bappa non è un idolo muto, cioè non è un idolo normale. Così per tutta risposta Karan/Ganesh viene preso in giro e insultato dalla gente e persino messo in discussione alla radice (non come divinità in sé, ma come divinità affidabile). Una donna molto semplice (assidua ai riti) gli dice addirittura di sospettare che non esista (Ganesh, non Karan). Karan è ridotto all’impotenza assoluta, l’immagine tradizionale dell’idolo di Ganesh venuto in terra per aumentare la devozione al dio Ganesh “vero e proprio” (immagine che lui stesso aveva proposto), grazie a Bappa, viene inesorabilmente buttata giù. E allora che succede? Che Karan/Ganesh smette di parlare chiaramente e comincia a blaterare suoni, terminando per emettere il celebre Om namah simaya (qualcosa, allega Grimaud, come mi arrendo a te, Dio o sia fatta la tua volontà).

Altri incarnanti sapranno superare meglio questo punto zero: Anand, un incarnante ateo che aveva iniziato dicendo di essere onnisciente e quant’altro la tradizione attribuisca a Ganesh di essere, di fronte a una fortissima invettiva di un conducente di autobus che in una sorta di comizio/giudizio denuncia la corruzione dilagante e quindi reclama a gran voce licenza a Ganesh di farsi giustizia con le proprie mani, comprende che è meglio nascondere la propria identità (il proprio potenziale) il più possibile. Dare meno informazioni su di sé gli evita imbarazzo (e ne alleggerisce il ruolo conversazionale) così preferisce non promettere né proporre nulla. Contrariamente alla prassi usuale manifesta lui stesso interesse per la vita dei suoi interlocutori e delle sue interlocutrici e comincia a porre loro delle domande. Ascoltando attivamente chi lo interpella Anand/Ganesh finirà per dichiarare di non poter fare tutto e addirittura (alla terza incarnazione) riuscirà a far digerire alla gente una nuova immagine di dio: un dio-specchio, che ha bisogno di ascoltare e riflettere prima di rispondere (se ne sarà capace) e delega agli umani la risoluzione dei problemi che loro stessi hanno generato. O ancora il caso della giovane (omosessuale) Jyot che incarna un Ganesh non-genre (dato che trans includerebbe un numero troppo limitato di possibilità secondo lei) un Ganesh controintuitivo, che si diverte a porre enigmi a chi viene a chiedergli qualcosa o a lasciare risposte in sospeso. Simile al Ganesh della giovane Varsha che, esplorando temi cosmologici, si ritrova a dire cose anarchiche, atee e panteiste che, ammetterà in seguito, prima dell’incarnazione non sospettava neanche di pensare!

Teologie a parte, l’interesse profondo dell’esperimento (anche rispetto al tema di questo articolo) sta nella perturbazione generata dalla macchina. Gli interlocutori vengono obbligati a ri-genererare il senso di divino, umano e artificiale. Questa disponibilità a re-settare le proprie logiche (non necessariamente le proprie intere visioni del mondo), mostra che gli umani, contrariamente alle apparenze, non hanno concetti chiari e duri degli elementi che compongono il loro mondo. In termini metafisici [10]: le cose non sono sostanze di cui si possono conoscere significati (sensi) rigidi ma qualcosa che nel magma ontologicamente indistinto dell’interazione arriva, accade, si compone, emerge come un mulinello in un fiume, come un effetto, nel senso fisico di effetto Doppler o Faraday [11].

Una prospettica antropologica: bappa e la intelligenza artificiale a confronto

Una prospettica antropologica: bappa e la intelligenza artificiale a confronto

Se l’esperimento di Grimaud riconsegna le sostanze aristoteliche a un magma ontologicamente indistinto, non bisogna tuttavia immaginarsi che l’esistenza tutta sia cieca come la famosa notte delle vacche nere. Molto semplicemente gli enti si stagliano su un fondo oscuro che è destinato a nutrirli, cambiarli, combinandoli attraverso l’interazione in cristalli, in composti provvisori. Per quanto riguarda l’interazione studiata da Grimaud è possibile attraverso l‘analisi fissare alcuni momenti-chiave. Grimaud ne dettaglia e codifica sei, per poi disporli su una sorta di plateau in cui identificare non tanto identità provvisorie ma attriti, effetti di soglia, linee di movimento. La scelta è sensata: l’analisi dell’esperimento che ne risulta è molto precisa e straordinariamente intelligente.

Nondimeno, parte di questo esercizio e dei concetti che Grimaud utilizza (traducendoli in sigle molto efficaci ma abbastanza difficili da decodificare e spiegare a chi non conosce il suo lavoro), esulano dagli obiettivi di questo articolo, ragion per cui preferisco concentrare l’attenzione di chi legge solo sulle soglie indispensabili al trapianto mentale dell’esperimento di Grimaud nel campo dell’intelligenza artificiale. Mi sembra che grazie al suo lavoro risulti adesso un po’ più facile proiettarsi in un futuro ormai imminente (e in parte già presente per molti di noi), in cui l’umanità si ritroverà a interagire con l’intelligenza artificiale proprio come è successo a passanti e incarnanti con Bappa per le strade di Bombay. Non essendoci dubbio che, come nel caso del simpatico idolo semielettronico, l’intelligenza artificiale genererà moltissime perturbazioni, azzardo una (pre-) visione immaginaria di come andranno le cose, sulla falsariga dell’esperimento di Bappa. Per facilitare la lettura ho decodificato le belle sigle di Grimaud in una prosa più accessibile a chi non ha letto il libro, sottolineando le parole o parafrasi che vi corrispondono [12].

L’attrazione che l’intelligenza artificiale eserciterà sugli umani sarà fortissima, specie perché, similmente a Bappa, inviterà a esercizi sempre più promettenti ma, a differenza che con la macchina di Grimaud e Paré, tutt’altro che impossibili. Per la stessa natura delle due intelligenze interagenti ciò che fallirà alla prima interazione funzionerà certamente alla seconda. Alla lunga, esattamente come a Bombay, non si produrranno troppo frequentemente i temuti equivoci circa la verità della macchina ovvero circa l’umanità dell’intelligenza con cui si sta interagendo [13]. La fase cinetica del sospetto, l’approssimarsi fra lo scettico e il prudente alla macchina, sarà sicuramente abbreviata e rapidamente azzerata (mancando la variabile umana dell’incarnante). La curiosità di esplorare tutte le possibilità dell’interazione con la macchina – in un umano che, come vogliono gli e le apocalittic* della terza posizione, prima di trans-umanare nel suo point zéro preferirà restare fedele fino all’ultimo alla propria insaziabile voglia, più o meno moderna, di divenir del mondo esperto – sarà invincibile.

Qui finisce ciò che antropologicamente si può, a mio avviso, prevedere [14]. La rigenerazione (la funzione di reset) è ancora magmatica. E se crediamo a Grimaud lo resterà anche dopo. Quel che è certo è che ci sarà e riguarderà anche le macchine stesse. D’altra parte già André Leroy-Gourhan notava, nel 1964 [15], che l’umanità cambia un po’ di specie ogni volta che cambia di strumenti e istituzioni. In ogni caso: se operare una svolta ontologica in antropologia significa sfidare l’assunzione che ci sia una sola realtà universale e un numero finito di ontologie [16], non c’è dubbio che l’interazione con l’intelligenza artificiale costituirà un momento pratico tanto di questa svolta che di quel cambiamento di specie [17]. Come osserva infatti lo stesso Grimaud, Bappa non è soltanto un giocattolo metafisico (nel senso deteriore, di astrattezza fine a se stessa, del termine, senso che non ho usato fino nell’articolo). Ed è molto probabile che i sistemi di intelligenza artificiale non lo siano nemmeno. Molti e molte partecipanti, all’esperimento oltre che per una critica radicale del contratto economico tipico della religiosità tradizionale, si sono servit* di Bappa per far passare messaggi politici (ecologia, denuncia, campagne di sensibilizzazione a minacce per la salute…), trasformando l’interazione in un tribunale dove attribuire o re-attribuire responsabilità e incarichi [18]. Sommettendo l’incarnante a processo hanno rimesso in questione il concetto di rappresentazione del dio nell’idolo e persino l’efficacia di dio stesso. La pratica dialogica ha finito in modo del tutto naturale per ridistribuire responsabilità e capacità di agire.

Non è forse questo che, in linea di massima, cerchiamo di perseguire anche con l’intelligenza artificiale? Delegare alla macchina quel che noi, da sol*, non riusciamo facilmente a portare a compimento. Suleyman parla al riguardo, direi correttamente, di una frammentazione di potere. Ma questa ricerca di aumentata agentività a maggior gloria di chi dovrebbe andare? Non della macchina (come temono molti e molti altri desiderano) ma nostra. E ci andrà senza dubbio come direbbero gli e le umanist* ingenu* (e con una sfumatura crudelmente diversa sul possessivo anche gli e le pragmatic*). Ma Daniel Andler pensa, lucidamente, di non poter escludere il contrario: «S’assurer qu’une super-intelligence autonome reste au service des humains ou de l’humanité en général semble difficile, sinon impossible.» Il noto matematico considera la creazione di un ‘intelligenza artificiale autonoma incerta, pericolosa e inutile. Le ragioni sono ovvie. È più che probabile che un’interazione con un’intelligenza artificiale autonoma ci scaraventerebbe molto velocemente a un point zéro tale che difficilmente (più difficilmente di quanto già succede adesso con sottointelligenze artificiali semplici in attività[19]) ci porterebbe a una rigenerazione equamente soddisfacente come prima dell’interazione.

Questo caveat dovrebbe valere parzialmente anche per le intelligenze artificiali non autonome attualmente correnti. Grimaud ha messo insieme persone libere, che grazie a una macchina hanno inter-agito in vista, in primo luogo, del semplice scopo di cooperare [20]. Per questo ritengo che non sono gli usi creativi dell’intelligenza artificiale cosiddetta generativa a doverci preoccupare (p.e. chatboxes produttrici di testi o immagini) ma quelli costrittivi (p.e. biometria, usi legali, sanitari, valutazioni di credito, accesso al lavoro, alle cure…) dove la nostra unica possibilità di interagire con chi sta dietro la macchina (che agisce per un suo scopo, uno scopo che non è, in quei casi, anche nostro) è puramente passiva (e spesso non libera). I point zéro dove ci porterebbero questo tipo di interazioni non sono certamente disperati come quelli che ci regalerebbe un’intelligenza artificiale autonoma ma ci costringerebbero probabilmente a strategie rigenerative necessariamente violente.

E allora: a quali condizioni interattive può un point zéro portarci a rigenerazioni accettabili e persino auspicabili, come quelle evocate dalla citazione di Galimberti in apertura a questo articolo («Siamo tutti persuasi di abitare l’età della tecnica, di cui godiamo i benefici in termini di beni e spazi di libertà. Siamo più liberi degli uomini primitivi perché abbiamo più campi di gioco in cui inserirci.»)? Andler ne identifica due. La prima è di ordine politico (e non potrebbe essere altrimenti): decidere di avere sempre un controllore umano per ogni sistema di intelligenza artificiale (ovvero decidere di smettere di cercare di produrne di autonomi). La seconda è di ordine morale: usare un principio di moderazione (ovvero ricorrere all’intelligenza artificiale soltanto quando farlo dia vantaggi largamente superiori agli inconvenienti e ai rischi). La prima mi convince, la seconda mi sembra, guardando l’attualità, mancare di realismo. Per parte mia ritengo che nel gran mare che ci attende la prima e più importante capacità da sviluppare sarà quella di

a) non chiudere i nostri porti all’interazione con l’intelligenza artificiale;

b) e apprendere a rinavigare le acque della nostra intelligenza (comprendendo, con Andler, che non è qualcosa di misurabile in numeri, anche se si manifesta attraverso capacità di cui le macchine dispongono in maniera superiore alla nostra, ma una norma che si applica a un comportamento, come quando si dice che qualcuno è intelligente, dando a intendere che i dettagli sarebbero troppi);

c) e soprattutto allargando le nostre responsabilità (invece di usare le macchine per evitarle).

Così come nell’era della tecnica l’unico dio accettabile (perché rigenerante) è un composto provvisorio di umanità plurale, tecnica e sovrannaturale, ritengo che l’unica forma di intelligenza che dovremmo essere dispost* ad accettare dovrebbe essere frutto di libera e cosciente interazione fra viventi, quanto più non-violenta possibile e possibilmente liberante.

Dialoghi Mediterranei, n. 65, gennaio 2024

Note

[1] Andler distingue l’enigma, dal mistero e dal problema. Il mistero è qualcosa che ci supera totalmente, il problema corrisponde a un compito difficile ma alla nostra portata. L’enigma sta fra i due: qualcosa ci paralizza ma allo stesso tempo ci sfida a risolverlo. Secondo Andler l’intelligenza artificiale ha su di noi l’effetto di un enigma.

[2] Consulto il libro in edizione elettronica. Pertanto non posso fornire il numero di pagina relativo alla citazione. Nel prosieguo dell’articolo sarò costretto a procedere allo stesso modo (valga questo avviso per tutti i casi seguenti). Segnalo anche, per scrupolo di precisione, che il filosofo, in verità, mette in esergo il noto passo heideggeriano sull’inquietante inabilità umana a confrontarsi in modo meditato con il fenomeno emergente (anni ’50 del ventesimo secolo) della tecnica.

[3] Sui tremendi rischi legati all’intelligenza artificiale, sui suoi non pochi vantaggi e sulla necessità di contenimento del fenomeno v. Sulyeman. Per una visione più completa del fenomeno Andler.

[4] Per una disamina di tutte le posizioni (sia quelle apocalittiche che quelle integrate, in ogni grado di intensità) v. le riviste IA. Le mythe du XXI siècle (Hors-série Philomag Printemps 2023) e Transhumanisme. Le nouveau meilleur des mondes (Frontpopulaire, 2023: 14).

[5] Cf. p.e. N. Bostrom (anche oltre l’opera ormai classica in bibliografia).

[6] V. fra molti altri v. i poderosi e ottimi lavori di E. Sadin e R. Liogier.

[7] La posizione fatalista ovviamente non dice nulla.

[8] Note le giuste preoccupazioni verso le future (in realtà imminenti) prassi del lavoro, dell’educazione, della distribuzione di credito, della sanità, della giustizia, della sicurezza e potrei continuare. V. Suleyman.

[9] Qui Grimaud evoca anche il celebre invito di Tim Ingold a mettere nella ricerca antropologica the people in.

[10] Cf. l’ottima prefazione di P. Manglier allo studio di Grimaud (2021).

[11] Fortissimo il debito di Grimaud (e riconosciuto esplicitamente dallo stesso autore nel libro) verso Foucault e Deleuze.

[12] Qui le sigle originali in ordine di apparizione nel mio testo: ATTRACT (area d’attrazione), ONTO (zona di ambiguità ontologica), SPECTR (spettro di fluttuazione), NEG (spazio del negoziato), TURB (zona di turbolenze mondane).

[13] Qui mi riferisco all’interazione. Ben altra questione gli equivoci di realtà e verità riguardo ai prodotti dell’interazione, problema risolvibile soltanto da un quadro legale molto stretto. Mentre scrivo mi giunge la notizia che Amazon ha dovuto limitare a tre al giorno il numero di manoscritti consegnati a pubblicazione su Kindle da uno stesso autore (v. Vulser). Sul rapporto fra realtà e artificialità cf. Grimaud (2021 e 2011) in particolare per il concetto (mutuato da Masahiro Mori) di uncanny valley, che si riferisce all’inquietudine (e persino repulsione) che può sorgere negli umani esposti a una macchina simile a un essere umano. Sulle prime si direbbe che quanto più forte è la somiglianza minore è l’inquietudine, salvo poi dover verificare che se a bassi livelli di somiglianza sono proprio le caratteristiche somiglianti a colpire l’attenzione degli umani, a partire dall’identificazione della macchina con l’umano (anche emotiva), generata proprio dalle caratteristiche somiglianti, sono le differenze a prendere il sopravvento nella percezione umana, fino alla repulsione.

[14] Cf. Suleyman che a partire dalla storia della tecnica fa previsioni anche più dettagliate delle mie.

[15] Riecheggio Grimaud (2011: 26).

[16] Sulla svolta ontologica in antropologia v. Coccia, Descola e Kohn.

[17] Esperienza probabilmente del tutto incosciente, non essendo tutti gli esseri umani antropolog* di vocazione.

[18] La sigla di Grimaud è TURB (v. n. 12). Osserva lo stesso Grimaud che dopo un’iniziale diffidenza Bappa è diventato richiestissimo fra gli abitanti di Bombay.

[19] Si pensi a quanto tempo provano già a rubarci le reti sociali o le pagine di intrattenimento (come YouTube) con offerte personalizzate e additive.

[20] Per riprendere una nota tesi di Umberto Galimberti sull’età della tecnica: il tragico del nostro tempo (era il 2008 ma la tesi mi sembra ancora valida) è lo spostamento forzato dall’agire al fare, dove agire sta per compiere delle azioni in vista di uno scopo e fare per eseguire bene un compito senza essere responsabile dello scopo finale. L’accesso alle relazioni mediate dall’intelligenza artificiale non sarà sempre libero, volontario e paritario. L’agire e il fare non saranno sempre equamente distribuiti. E neanche questa, in fondo, è una novità dell‘ultima ora. (2008: 19-21).

Riferimenti bibliografici

ANDLER, Daniel. 2023. Intelligence artificielle, intelligence humaine: la double énigme (Gallimard: Paris).

BOSTROM, Nick. 2014. Superintelligence. Paths, Dangers, Strategies, (Oxford University Press: Oxford UK).

COCCIA, Emanuele. 2021. Prefazione all’edizione italiana: L’io è una foresta (Nottetempo: Milano) in Eduardo Kohn. Come pensano le foreste. Per un’antropologia oltre l’umano ( How Forests Think: Toward an Anthropology Beyond the Human (University of California Press: Berkeley and Los Angeles, California / University of California, Ltd.: London, England, 2013).

DESCOLA, Philippe. 2017. La forêt des signes (Zones sensibles, Paris) in Eduardo Kohn, Comment pensent les forêts. Vers une anthropologie au-delà de l’humain (How Forests Think: Toward an Anthropology Beyond the Human (University of California Press: Berkeley and Los Angeles, California / University of California, Ltd.: London, England).

GALIMBERTI, Umberto. (1999). Psiche e techne. L’uomo nell’età della tecnica (Feltrinelli: Milano).

_ .2008. La morte dell’agire e il primato del fare nell’età della tecnica (Albo Versorio: Milano).

_ . 2023. L’etica del viandante (Feltrinelli: Milano).

GRIMAUD, Emmanuel. 2021. Dieu point zéro. Une anthropologie expérimentale (Presses Universitaires de France / Humensis: Paris).

GRIMAUD, Emmanuel / Zaven Paré. 2011. Le jour où les robots mangeront des pommes (Pétra: Paris).

GROSOS, Philippe. 2023. La philosophie au risque de la préhistoire (Cerf: Paris).

KOHN, Eduardo. 2013. How Forests Think: Toward an Anthropology Beyond the Human (University of California Press: Berkeley and Los Angeles, California / University of California, Ltd.: London, England).

LIOGIER, Raphaël. 2023. Khaos. La promesse trahie de la modernité (Les Liens qui Libérent: Paris).

MANGLIER, Patrice. 2021. À la place de dieu. Le tournant expérimental en anthropologie et ses enjeux métaphysiques Presses Universitaires de France / Humensis: Paris) in Emmanuel Grimaud, Dieu point zéro. Une anthropologie expérimentale.

SADIN, Eric. 2023. La vie spectrale. Penser l’ère du metavers et des IA génératives (Grasset: Paris).

SULEYMAN, Mustafa with Michael Bhaskar. 2023. The Coming Wave. AI, Power and the Twenty-First Century’s Greatest Dilemma (The Bodley Head: London).

VULSER, Nicole. Amazon submergé par les faux livres écrits par l’IA in Le Monde 14.12.2023.

______________________________________________________________

Francesco Azzarello, è stato segretario della Scuola di formazione etico-politica “Giovanni Falcone”, ha partecipato a varie attività antimafia collaborando con diverse associazioni palermitane. In Germania dal 1997, ha studiato Filologia romanza e Filosofia a Colonia. Dal 2003 insegna Filologia romanza a Friburgo. Oltre alle pubblicazioni accademiche in linguistica, letteratura e storia della cultura ha scritto di mafia, filosofia, teologia interreligiosa e altro. Dal 2015, con alcuni amici, accompagna diverse famiglie di profughi nel percorso di integrazione in Germania.

______________________________________________________________